一段自然语言文本可以看作是一个给定一个长度为T T T w 1 , w 2 , … , w T w_1, w_2, \ldots, w_T w 1 , w 2 , … , w T

P ( w 1 , w 2 , … , w T ) . P(w_1, w_2, \ldots, w_T).

P ( w 1 , w 2 , … , w T ) .

假设序列w 1 , w 2 , … , w T w_1, w_2, \ldots, w_T w 1 , w 2 , … , w T

P ( w 1 , w 2 , … , w T ) = ∏ t = 1 T P ( w t ∣ w 1 , … , w t − 1 ) = P ( w 1 ) ⋅ P ( w 2 ∣ w 1 ) ⋅ P ( w 3 ∣ w 1 2 ) ⋯ P ( w T ∣ w 1 T − 1 ) \begin{aligned}

P(w_1, w_2, \ldots, w_T)

&= \prod_{t=1}^T P(w_t \mid w_1, \ldots, w_{t-1})\\

&= P(w_1)·P(w_2 \mid w_1)·P(w_3 \mid w_{1}^{2}) \cdots P(w_T \mid w_{1}^{T-1})

\end{aligned}

P ( w 1 , w 2 , … , w T ) = t = 1 ∏ T P ( w t ∣ w 1 , … , w t − 1 ) = P ( w 1 ) ⋅ P ( w 2 ∣ w 1 ) ⋅ P ( w 3 ∣ w 1 2 ) ⋯ P ( w T ∣ w 1 T − 1 )

其中,w 1 k w_{1}^{k} w 1 k 1 1 1 k k k

语言模型的参数就是词的概率以及给定前几个词情况下的条件概率。假设训练数据集为一个大型文本语料库,根据大数定理,词的概率可以通过该词在训练数据集中的相对词频来计算,这样,w k w_k w k

p ( w k ∣ w 1 k − 1 ) = p ( w 1 k ) p ( w 1 k − 1 ) ≈ c o u n t ( w 1 k ) c o u n t ( w 1 k − 1 ) p(w_{k} \mid w_{1}^{k-1})= \frac{p(w_{1}^{k})}{p(w_{1}^{k-1})}\approx \frac{count(w_{1}^{k})}{count(w_{1}^{k-1})}

p ( w k ∣ w 1 k − 1 ) = p ( w 1 k − 1 ) p ( w 1 k ) ≈ c o u n t ( w 1 k − 1 ) c o u n t ( w 1 k )

其中c o u n t ( w 1 k − 1 ) count(w_{1}^{k-1}) c o u n t ( w 1 k − 1 ) w 1 k w_{1}^{k} w 1 k

可见,随着序列长度增加,计算和存储多个词共同出现的概率的复杂度会呈指数级增加。解决这一问题,需要引入马尔可夫假设。

N N N 马尔科夫假设是指一个词的出现只与前面n n n

P ( w k ∣ w 1 k − 1 ) ≈ P ( w k ∣ w k − n + 1 k − 1 ) ≈ c o u n t ( w 1 k ) c o u n t ( w k − n + 1 k − 1 ) P(w_{k}\mid w_{1}^{k-1}) \approx P(w_{k}\mid w_{k-n+1}^{k-1}) \approx \frac{count(w_{1}^{k})}{count(w_{k-n+1}^{k-1})}

P ( w k ∣ w 1 k − 1 ) ≈ P ( w k ∣ w k − n + 1 k − 1 ) ≈ c o u n t ( w k − n + 1 k − 1 ) c o u n t ( w 1 k )

以上也叫N N N N N N n − 1 n-1 n − 1

当n n n 1 1 1 2 2 2 3 3 3 4 4 4 w 1 , w 2 , w 3 , w 4 w_1, w_2, w_3, w_4 w 1 , w 2 , w 3 , w 4

P ( w 1 , w 2 , w 3 , w 4 ) = P ( w 1 ) P ( w 2 ) P ( w 3 ) P ( w 4 ) , P ( w 1 , w 2 , w 3 , w 4 ) = P ( w 1 ) P ( w 2 ∣ w 1 ) P ( w 3 ∣ w 2 ) P ( w 4 ∣ w 3 ) , P ( w 1 , w 2 , w 3 , w 4 ) = P ( w 1 ) P ( w 2 ∣ w 1 ) P ( w 3 ∣ w 1 , w 2 ) P ( w 4 ∣ w 2 , w 3 ) . \begin{aligned}

P(w_1, w_2, w_3, w_4) &= P(w_1) P(w_2) P(w_3) P(w_4) ,\\

P(w_1, w_2, w_3, w_4) &= P(w_1) P(w_2 \mid w_1) P(w_3 \mid w_2) P(w_4 \mid w_3) ,\\

P(w_1, w_2, w_3, w_4) &= P(w_1) P(w_2 \mid w_1) P(w_3 \mid w_1, w_2) P(w_4 \mid w_2, w_3) .

\end{aligned}

P ( w 1 , w 2 , w 3 , w 4 ) P ( w 1 , w 2 , w 3 , w 4 ) P ( w 1 , w 2 , w 3 , w 4 ) = P ( w 1 ) P ( w 2 ) P ( w 3 ) P ( w 4 ) , = P ( w 1 ) P ( w 2 ∣ w 1 ) P ( w 3 ∣ w 2 ) P ( w 4 ∣ w 3 ) , = P ( w 1 ) P ( w 2 ∣ w 1 ) P ( w 3 ∣ w 1 , w 2 ) P ( w 4 ∣ w 2 , w 3 ) .

当n n n N N N n n n n n n

N N N 对于参数n n n 计算复杂度 和模型效果 两方面

计算复杂度:由于参数的个数是N + N 2 + ⋯ + N n N + N^{2} + \cdots + N^{n} N + N 2 + ⋯ + N n n n n

模型效果:理论上n n n n n n n n n 2 2 2 3 3 3

因此,实际工作中,最多的情况是取n = 3 n=3 n = 3

此外,还需要考虑到数据稀疏 的问题:在文本中经常出现的现象是,有些词出现的频率很低,但是很重要,有些词(如“的”、“和”)出现次数很多,但不重要。假如重要的词串在统计时计数为0 0 0 c o u n t ( w k − n + 1 k − 1 ) = 0 count(w_{k-n+1}^{k-1})=0 c o u n t ( w k − n + 1 k − 1 ) = 0 P ( w k ∣ w 1 k − 1 ) = 0 P(w_{k}\mid w_{1}^{k-1})=0 P ( w k ∣ w 1 k − 1 ) = 0 0 0 0 平滑化 』。

通常构造的目标函数是『最大似然函数 』

∏ w ∈ C p ( w ∣ C o n t e x t ( w ) ) \prod_{w\in C} p(w|Context(w))

w ∈ C ∏ p ( w ∣ C o n t e x t ( w ) )

其中

C C C C o n t e x t ( w ) Context(w) C o n t e x t ( w ) w w w C o n t e x t ( w i ) = w i − n + 1 i − 1 Context(w_i)=w_{i-n+1}^{i-1} C o n t e x t ( w i ) = w i − n + 1 i − 1

实际上由于连乘可能导致概率极小,所以经常采用的是『最大对数似然 』,即目标函数为:

L = ∑ w ∈ C l o g p ( w ∣ C o n t e x t ( w ) ) 将 条 件 概 率 p ( w ∣ C o n t e x t ( w ) ) 视 为 关 于 w 和 C o n t e x t ( w ) 的 函 数 = ∑ w ∈ C l o g F ( w , C o n t e x t ( w ) , θ ) \mathcal{L}=\sum_{w\in C}log \, p(w|Context(w)) \\ 将条件概率p(w|Context(w))视为关于w和Context(w)的函数 \\ = \sum_{w\in C}log \, F(w,Context(w),\theta)

L = w ∈ C ∑ l o g p ( w ∣ C o n t e x t ( w ) ) 将 条 件 概 率 p ( w ∣ C o n t e x t ( w ) ) 视 为 关 于 w 和 C o n t e x t ( w ) 的 函 数 = w ∈ C ∑ l o g F ( w , C o n t e x t ( w ) , θ )

其中是θ \theta θ θ ∗ \theta^* θ ∗ F F F F F F θ \theta θ

数据集(点击查看下载) 是周杰伦从第一张专辑《Jay》到第十张专辑《跨时代》中的歌词,这里将其转换成字符级循环神经网络所需要的输入格式,之后将用于循环神经网络来训练一个语言模型。

deeplearning_02.py view raw 1 2 3 4 5 6 7 8 9 10 11 12 def load_data_jay_lyrics () : with open('../jaychou_lyrics.txt' ) as f: corpus_chars = f.read() corpus_chars = corpus_chars.replace('\n' , ' ' ).replace('\r' , ' ' ) corpus_chars = corpus_chars[0 :10000 ] idx_to_char = list(set(corpus_chars)) char_to_idx = dict([(char, i) for i, char in enumerate(idx_to_char)]) vocab_size = len(char_to_idx) corpus_indices = [char_to_idx[char] for char in corpus_chars] return corpus_indices, char_to_idx, idx_to_char, vocab_size

在训练时需要每次随机读取小批量样本和标签。注意,时序数据的一个样本通常包含连续的字符,而样本的标签序列为这些字符分别在训练集中的下一个字符。

想要有直升机,想要和你飞到宇宙去

X X X Y Y Y X X X Y Y Y X X X Y Y Y …

X X X Y Y Y X X X Y Y Y X X X Y Y Y

可见,如果序列的长度为T T T n n n T − n T-n T − n

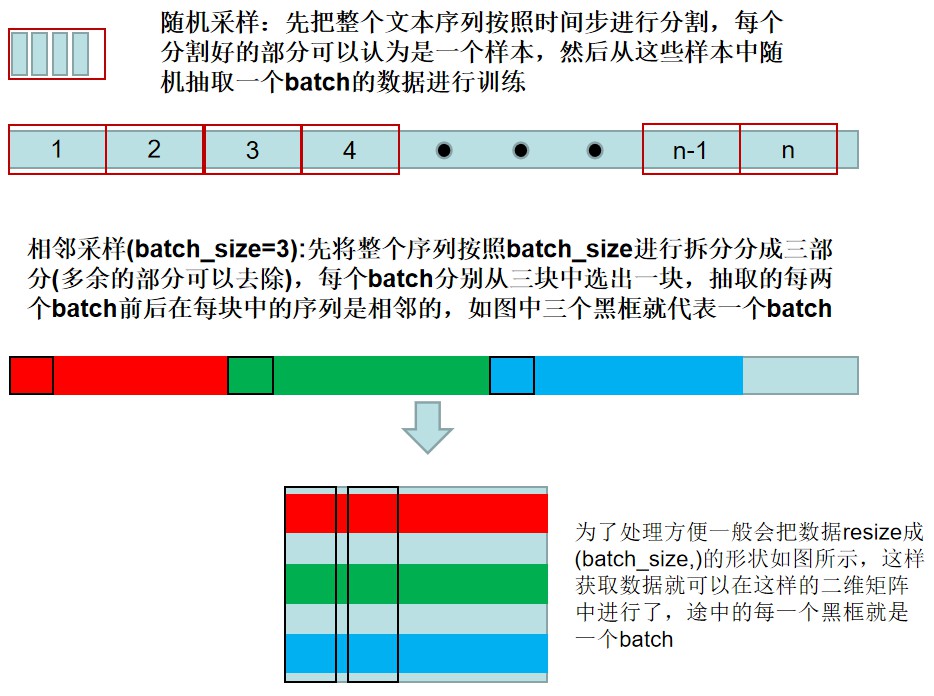

下面的代码每次从数据里随机采样一个小批量。其中批量大小batch_size指每个小批量的样本数,num_steps为每个样本所包含的时间步数。 在随机采样中,每个样本是原始序列上任意截取的一段序列。相邻的两个随机小批量在原始序列上的位置不一定相毗邻。因此,无法用一个小批量最终时间步的隐藏状态来初始化下一个小批量的隐藏状态。在训练模型时,每次随机采样前都需要重新初始化隐藏状态。

deeplearning_02.py view raw 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 import torchimport randomdef data_iter_random (corpus_indices, batch_size, num_steps, device=None) : num_examples = (len(corpus_indices) - 1 ) // num_steps example_indices = [i * num_steps for i in range(num_examples)] random.shuffle(example_indices) def _data (i) : return corpus_indices[i: i + num_steps] if device is None : device = torch.device('cuda' if torch.cuda.is_available() else 'cpu' ) for i in range(0 , num_examples, batch_size): batch_indices = example_indices[i: i + batch_size] X = [_data(j) for j in batch_indices] Y = [_data(j + 1 ) for j in batch_indices] yield torch.tensor(X, device=device), torch.tensor(Y, device=device)

在相邻采样中,相邻的两个随机小批量在原始序列上的位置相毗邻。

deeplearning_02.py view raw 1 2 3 4 5 6 7 8 9 10 11 12 13 def data_iter_consecutive (corpus_indices, batch_size, num_steps, device=None) : if device is None : device = torch.device('cuda' if torch.cuda.is_available() else 'cpu' ) corpus_len = len(corpus_indices) // batch_size * batch_size corpus_indices = corpus_indices[: corpus_len] indices = torch.tensor(corpus_indices, device=device) indices = indices.view(batch_size, -1 ) batch_num = (indices.shape[1 ] - 1 ) // num_steps for i in range(batch_num): i = i * num_steps X = indices[:, i: i + num_steps] Y = indices[:, i + 1 : i + num_steps + 1 ] yield X, Y

这里构造一个数字序列,设置batch_size=2, num_steps=6来测试上述采样代码

deeplearning_02.py view raw 1 2 3 4 5 test_seq = list(range(100 )) for X, Y in data_iter_random(test_seq, batch_size=2 , num_steps=6 ): print('随机采样测试:' , '\nX: ' , X, '\nY:' , Y, '\n' ) for X, Y in data_iter_consecutive(test_seq, batch_size=2 , num_steps=6 ): print('相邻采样测试:' , '\nX: ' , X, '\nY:' , Y, '\n' )

随机采样测试:

相邻采样测试:

图中每个框的宽度代表num_steps,每一个小框(颜色相同)代表一个样本,batch_size个样本组成一个batch。